少し遅れてしまいましたが、2016/Jul/02 に Ruby の Web アプリケーションフレームワークである Rails の最新バージョン 5.0 のリリースが発表されました:

This Week In Rails: Rails 5 is out with new guides and more!

早速インストールしてみたので、その手順を紹介します。対象は CentOS 6.x とします。また導入手順としては rbenv を使って Ruby 本体を導入し、続けて gem で Rails 5.0 を導入します。

まずは Ruby の導入です。CentOS の場合、Ruby は "yum install ruby" で導入することも可能ですが、デフォルトで導入される Ruby のバージョンが少し低い(1.8.x)ので、rbenv を使って 2.x を導入することにします。なお Rail 5.0 のサポート Ruby バージョンは 2.2 以上とのことです。

というわけで、最初に rbenv を導入します。rbenv の導入前提として git が、そして rbenv を使って Ruby 2.x を導入する際の前提としていくつかの開発用ライブラリ必要になります。先に導入しておきましょう:

では改めて rbenv を導入します:

最後に /etc/profile に次の3行を追加します:

そして一旦ログアウトして再ログインします(編集した /etc/profile を読み込んで rbenv を有効にします)。

更に ruby-build を導入して、rbenv で install コマンドを実行できるようにしておきます:

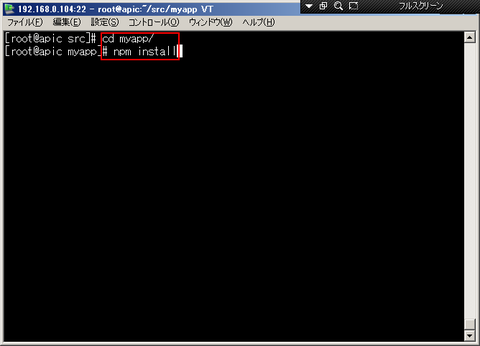

ここまでの準備が長かったのですが、これで rbenv が導入できました。rbenv を使って、今回は Ruby 2.2.5 を導入します:

Ruby が導入できたことを確認し、最後に gem を使って Rails 5.0 を導入します:

導入できましたー!

This Week In Rails: Rails 5 is out with new guides and more!

早速インストールしてみたので、その手順を紹介します。対象は CentOS 6.x とします。また導入手順としては rbenv を使って Ruby 本体を導入し、続けて gem で Rails 5.0 を導入します。

まずは Ruby の導入です。CentOS の場合、Ruby は "yum install ruby" で導入することも可能ですが、デフォルトで導入される Ruby のバージョンが少し低い(1.8.x)ので、rbenv を使って 2.x を導入することにします。なお Rail 5.0 のサポート Ruby バージョンは 2.2 以上とのことです。

というわけで、最初に rbenv を導入します。rbenv の導入前提として git が、そして rbenv を使って Ruby 2.x を導入する際の前提としていくつかの開発用ライブラリ必要になります。先に導入しておきましょう:

# yum install git gcc make openssl-devel libffi-devel readline-devel

では改めて rbenv を導入します:

# cd /opt # git clone git://github.com/sstephenson/rbenv.git # mkdir /opt/rbenv/plugins # cd /opt/rbenv/plugins # git clone git://github.com/sstephenson/ruby-build.git

最後に /etc/profile に次の3行を追加します:

export RBENV_ROOT="/opt/rbenv"

export PATH="${RBENV_ROOT}/bin:${PATH}"

eval "$(rbenv init -)"そして一旦ログアウトして再ログインします(編集した /etc/profile を読み込んで rbenv を有効にします)。

更に ruby-build を導入して、rbenv で install コマンドを実行できるようにしておきます:

# cd /usr/local/src # git clone git://github.com/sstephenson/ruby-build.git # cd ruby-build # ./install.sh

ここまでの準備が長かったのですが、これで rbenv が導入できました。rbenv を使って、今回は Ruby 2.2.5 を導入します:

# rbenv install 2.2.5

:

# rbenv global 2.2.5

# ruby -v

ruby 2.2.5p319 (2016-04-26 revision 54774) [x86_64-linux] <- 確認

Ruby が導入できたことを確認し、最後に gem を使って Rails 5.0 を導入します:

# gem update --system

# gem install rails -v 5.0.0

# gem install bundler

# rbenv rehash

# rails -v

Rails 5.0.0 <- 確認

導入できましたー!